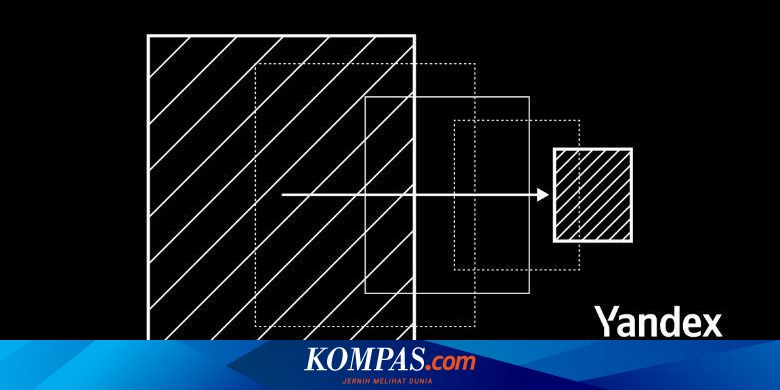

virprom.com – Yandex Research Group bekerja sama dengan peneliti dari Institut Sains dan Teknologi Austria (IST), NeuralMagic, dan Universitas Sains dan Teknologi King Abdullah (KAUST). Kolaborasi ini berhasil mengembangkan dua metode kompresi inovatif untuk model bahasa besar (LLM), yaitu Additive Quantization of Language Models (AQLM) dan PV-Tuning.

Dalam keterangan tertulis yang diterima virprom.com, Selasa (23/07/2024), pengembangan kedua metode tersebut diklaim memungkinkan model diturunkan hingga 8 kali lipat dengan tetap menjaga kualitas jawaban hingga 95. persen. .

Teknik-teknik ini dikembangkan untuk mengoptimalkan sumber daya dan meningkatkan efisiensi saat menggunakan model bahasa besar.

Makalah penelitian tentang pendekatan ini dipresentasikan pada Konferensi Internasional tentang Pembelajaran Mesin (ICML) di Wina, Austria.

Baca juga: Yandex Terdaftar di PSE Kominfo, Ingin Memberi Manfaat bagi Komunitas Digital Indonesia

Sistem AQLM menggunakan metode kuantisasi augmented atau pendekatan untuk menggabungkan himpunan besar menjadi himpunan kecil untuk melakukan kompresi LLM. Secara umum, metode ini biasanya digunakan untuk mengambil data.

Metode yang dihasilkan mampu mempertahankan bahkan meningkatkan akurasi model dalam kondisi kompresi tinggi, sehingga memungkinkan LLM digunakan pada perangkat sehari-hari seperti komputer rumah dan ponsel pintar. Faktanya, penggunaan memori bisa dikurangi secara signifikan.

Pada saat yang sama, PV-Tuning mampu mengatasi kesalahan yang mungkin muncul selama proses pengemasan model.

Jika digabungkan, AQLM dan PV-Tuning memberikan hasil terbaik sehingga model dapat memberikan respons berkualitas tinggi bahkan dengan opsi penyimpanan terbatas.

Baca Juga: Perusahaan Mesin Pencari Yandex Bahas AI dengan UPI dan Presentasi Mat dan Strategi Unpad

Evaluasi atau penilaian efektivitas metode dilakukan dengan menggunakan model open source populer seperti Llama 2, Llama 3 dan Mistral.

Peneliti mengabstraksi LLM dan menilai kualitas respon yang diperoleh terhadap tolok ukur bahasa Inggris, yaitu WikiText2 dan C4.

Hasil evaluasi menunjukkan bahwa metode ini mampu mempertahankan kualitas respons 95 persen yang mengesankan saat model dikompresi sebanyak 8 kali.

Jadi siapa yang bisa mendapatkan keuntungan dari AQLM dan PV-Tuning?

Baca Juga: Polisi Geledah Website Yandex yang Mendorong Pemuda Makassar Bunuh Bocah 11 Tahun

Metode baru ini menawarkan penghematan sumber daya yang signifikan bagi perusahaan yang terlibat dalam pengembangan dan penggunaan model bahasa mereka sendiri atau LLM sumber terbuka.

Misalnya model Llama 2 dengan 13 miliar variabel. Setelah dikompresi, model ini hanya dapat berjalan pada 1 GPU, tidak diperlukan lebih dari 4 GPU. Dengan cara ini, biaya perangkat keras dapat dikurangi hingga 8 kali lipat.

Ini berarti bahwa startup, peneliti individu, dan penggemar LLM dapat menjalankan LLM tingkat lanjut seperti Llama di komputer mereka sehari-hari.